(写真はイメージです/PIXTA)

(写真はイメージです/PIXTA)

1―DeepSeekの衝撃

AI開発を手がける中国の新興企業DeepSeekが開発したAIモデルが低コストでありながらベンチマークテストにおいてChatGPTと同等の高スコアを記録したことが注目を集めた*1。大規模言語モデル(Large Language Model:LLM)などAIモデルの開発は資金力に優れる米国のテック企業が主導してきたが、その優位を揺るがすとの見方が広がった。

DeepSeekの登場は、オープンソースによる大規模言語モデルの改良を加速させると期待されており、世界的にAI技術の開発競争に拍車がかかるとみられる。これにより、資金力に依存せずとも高性能なAIが構築可能となる可能性が広がり、生成AIの利用がより幅広い層に浸透する契機となるだろう。

また、AI開発の効率化により、特定の用途に特化したAIの導入コストも引き下げられると考えられており、製造、金融、教育など多様な産業での活用が進むことが期待されている。一方で、AIの処理を担う半導体需要は、一部で供給過多や価格下落の影響を受ける懸念も出ている。これが半導体市場全体の調整圧力となる可能性もある。ただし、エヌビディアなどのAI向けGPUに特化した企業は依然として高い注目を集めており、長期的なAI半導体需要の増加期待を背景に株価も堅調に推移している。DeepSeekの登場は世界のAIモデルの開発において米国の主要テック企業が独占する状況から様々な企業や開発者に裾野が広がる可能性がある。

*1:DeepSeekの低コスト化や性能については誇張があるとの指摘もあるが、本稿では近年のAIモデル改良の一例として、その性質や特徴について見ていきたい。

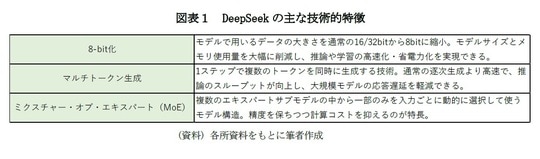

2―DeepSeekのモデルの特徴

DeepSeekの言語モデルは、最新の技術を積極的に取り入れ、高速で効率的かつ高性能な推論を実現している点が大きな特徴である。その代表的な技術要素として「8-bit化」、「マルチトークン生成」、「ミクスチャー・オブ・エキスパート(MoE)」の3つが挙げられる(図表1)。

まず8-bit化とは、従来の16-bitや32-bitの精度よりも桁数とデータ量が小さい8-bitで重みや演算を行うことで、計算資源を大幅に削減する技術である。これにより、モデルのメモリ消費量が減り、より小さなデバイスでも大規模言語モデルの運用が可能になる。特に推論時の計算コストを抑えることで、リアルタイム応答性の向上にも寄与している。DeepSeekではこの8-bit化を採用し、効率性と速度のバランスを高めている。

マルチトークン生成は、一度のステップで複数のトークン(単語や文字)を同時に生成するアプローチである。従来の言語モデルは1トークンずつ逐次生成していたため、長文生成には時間がかかっていたが、この手法により生成速度が大幅に改善された。DeepSeekはこの並列生成能力を活かし、対話応答や文章生成のスループットを向上させている。

ミクスチャー・オブ・エキスパート(Mixture of Experts: MoE)は、複数の専門的なサブモデルを組み合わせ、入力に応じて最適なものだけを動的に選択する構造である。すべてのサブモデルを毎回使うのではなく必要な部分だけを使うため、パラメータ数を抑えながらも表現力の高いモデルが実現可能だ。DeepSeekではこのMoE構造を採用し、大規模化による性能向上と計算効率の両立を図っている。こうした改善の組み合わせにより、DeepSeekは低コストで高い性能を実現している。